В январе 2017 года пользователи Reddit прочитали о предполагаемом случае терроризма в испанском супермаркете. Чего они не знали, так это того, что почти каждая деталь историй, взятых из нескольких бульварных публикаций и усиленных алгоритмами популярности Reddit, была ложной. Теперь исследование Корнельского университета показало, что побуждение людей активно участвовать в новостях, которые они потребляют, может уменьшить распространение такого рода лжи.

Натан Матиас, доцент кафедры коммуникации, провел эксперимент с 14-миллионным сообществом на Reddit и обнаружил, что поощрение людей к участию в сборе знаний может, по сути, сдвинуть стрелку алгоритма.

Он обнаружил, что предложение членам сообщества проверять подозрительные истории по фактам привело к тому, что эти истории были опущены в рейтинге Reddit.

“Один из уроков здесь заключается в том, что мы не должны думать о себе как о пленниках технологических платформ и алгоритмов”, – сказал Матиас, автор исследования, опубликованного в Scientific Reports.

Работая с лидерами сообщества волонтеров world news group на Reddit и уделяя особое внимание новостным сайтам с репутацией публикующих неточные утверждения, исследователи разработали программное обеспечение, которое отслеживало, когда участник сообщества отправлял ссылку для обсуждения. Затем программное обеспечение назначит обсуждению одно из трех условий:

Читателям было показано постоянное сообщение, призывающее их проверить статью по фактам и прокомментировать ее со ссылками на дополнительные доказательства, опровергающие утверждения статьи.

Читателям было показано сообщение и предложено рассмотреть возможность голосования против статьи. Участники сообщества, известные как “редакторы Reddit”, голосуют за статьи Reddit и, соответственно, ранжируют их.

А в контрольной группе никаких действий предпринято не было.

Матиас сказал, что он ожидал, что проверка фактов может иметь неприятные последствия. Если бы проверка фактов сосредоточила больше внимания на недостоверной истории, алгоритм мог бы расценить это как положительное подкрепление статьи и повысить ее рейтинг в среднем.

“Есть опасение, что если вы будете повторять ложь достаточно часто, закрепится ли это в чьем-то сознании?” он сказал. “И есть ли что-то похожее с этими алгоритмами рекомендаций, которые не обязательно могут отличить правильное от неправильного? Даже если вы проверяете факты, алгоритм может увидеть больше вовлеченности и показать это большему количеству людей”.”

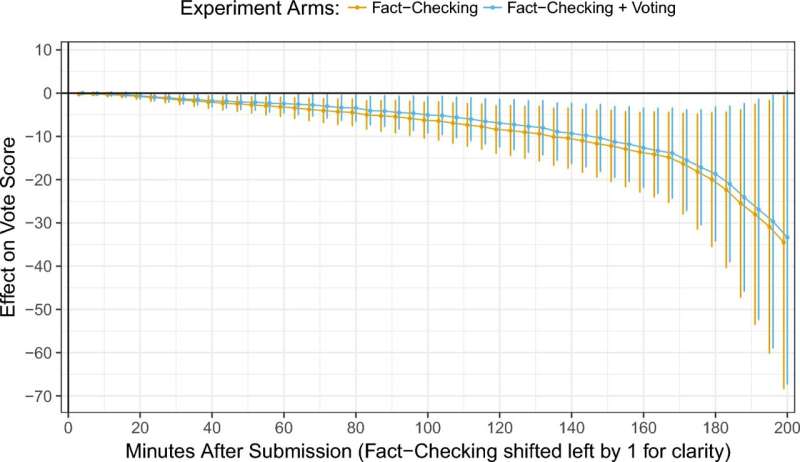

Оказалось, что это не так. Проанализировав в общей сложности 1104 обсуждения новостей, собранные с декабря 2016 по февраль 2017 года, Матиас обнаружил, что простое поощрение проверки фактов – даже без приглашения проголосовать против — привело к снижению рейтинга истории в среднем на минус 25 позиций. На Reddit это привело бы к тому, что статья исчезла бы с первой страницы и, вероятно, была бы пропущена значительным числом читателей.

Несмотря на то, что он проводился в узком масштабе, Матиас рассматривает свой эксперимент как доказательство того, что люди могут коллективно контролировать информацию, которой их кормят, а не просто принимать постоянную диету из лжи.

“Сейчас много говорят об идее детерминизма — о том, что решения инженера где-нибудь в Силиконовой долине влияют на наше сознание и привязывают нас к определенным моделям поведения”, – сказал он. “И хотя они действительно имеют влияние, эти системы сконструированы таким образом, чтобы реагировать на людей. Таким образом, когда люди работают вместе над улучшением нашей информационной среды, алгоритмы могут реагировать соответствующим образом.

“Это действительно мощный пример чего-то, что было очень практичным для этого сообщества, – сказал он, – и вносит фундаментальный вклад в научные знания”.